这里有最新的公司动态,这里有最新的网站设计、移动端设计、网页相关内容与你分享!

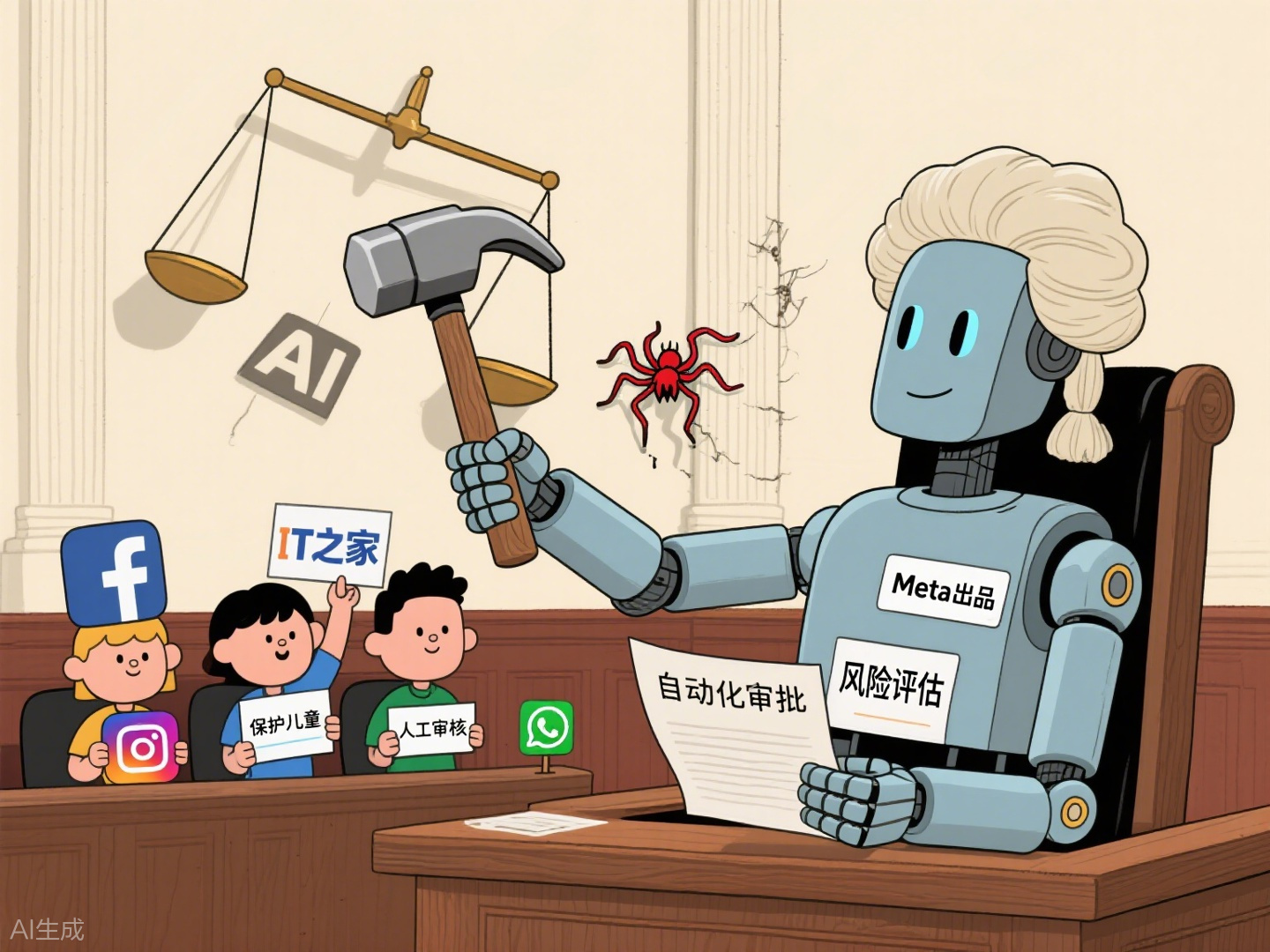

据《卫报》报道,6月9日的消息呼吁互联网安全活动家限制AI(AI)在关键风险评估中的使用。该电话会通知具有Facebook,Instagram和WhatsApp的Target计划自动化风险评估过程。在上个月的报告说,最多有90%的Facebook风险评估工作,Instagram的母公司和WhatsApp很快就会通过人工智能完成。根据《英国在线安全法》的说法,社交媒体平台必须评估平台上可能的有害风险,并制定相应的缓解措施以保护儿童用户,并避免出现非法内容。风险评估过程被认为是该法案之前的进口部分。几个组织,包括莫莉·罗斯基金会,全国预防协会虐待儿童(NSPCC)和Watch Internet基金会在致Ofcom首席执行官Melanie Dawes的信中说,AI促进的AI风险的使用是“回归且令人担忧的运动”。该组织在信函中强调:“我们建议您公开宣布,不应根据要求考虑完整或主要是通过自动化产生的风险评估。”这封信还要求监管机构质疑该平台可以试图简化风险评估过程的假设。 OFCOM发言人说:“我们清楚地问了通知任何已完成,审查和批准风险评估的人的服务。我们正在考虑这封信中提出的担忧,我们会及时回应。” Meta Resphe故意承担公司的安全职位。梅塔说,该公司致力于遵守法规并保持高标准的安全措施。 “我们没有使用AI来冒险Decisions。相反,我们的专家开发了工具来帮助设备确定特定产品是否满足法律和政治要求。人工不受员工的审查。P应用程序和新功能可以代表用户的“更大风险”,因为在发布新产品之前很难避免潜在的问题。 NPR还报告说,META正在考虑在诸如青少年风险和错误信息监测等微妙领域中自动化审核过程。

据《卫报》报道,6月9日的消息呼吁互联网安全活动家限制AI(AI)在关键风险评估中的使用。该电话会通知具有Facebook,Instagram和WhatsApp的Target计划自动化风险评估过程。在上个月的报告说,最多有90%的Facebook风险评估工作,Instagram的母公司和WhatsApp很快就会通过人工智能完成。根据《英国在线安全法》的说法,社交媒体平台必须评估平台上可能的有害风险,并制定相应的缓解措施以保护儿童用户,并避免出现非法内容。风险评估过程被认为是该法案之前的进口部分。几个组织,包括莫莉·罗斯基金会,全国预防协会虐待儿童(NSPCC)和Watch Internet基金会在致Ofcom首席执行官Melanie Dawes的信中说,AI促进的AI风险的使用是“回归且令人担忧的运动”。该组织在信函中强调:“我们建议您公开宣布,不应根据要求考虑完整或主要是通过自动化产生的风险评估。”这封信还要求监管机构质疑该平台可以试图简化风险评估过程的假设。 OFCOM发言人说:“我们清楚地问了通知任何已完成,审查和批准风险评估的人的服务。我们正在考虑这封信中提出的担忧,我们会及时回应。” Meta Resphe故意承担公司的安全职位。梅塔说,该公司致力于遵守法规并保持高标准的安全措施。 “我们没有使用AI来冒险Decisions。相反,我们的专家开发了工具来帮助设备确定特定产品是否满足法律和政治要求。人工不受员工的审查。P应用程序和新功能可以代表用户的“更大风险”,因为在发布新产品之前很难避免潜在的问题。 NPR还报告说,META正在考虑在诸如青少年风险和错误信息监测等微妙领域中自动化审核过程。 Copyright © 2024-2026 黑料百科 吃瓜爆料每日大赛的精彩内容 版权所有

沪ICP备32623652号-1